Nỗi lo ngại lớn

Trong bài viết nhan đề “Sự vũ khí hoá của trí tuệ nhân tạo” đăng trên tạp chí Forbes ngày 14-1-2019 đề cập đến xu hướng này. Bài viết nhận định: Cạnh tranh để dẫn đầu cuộc đua công nghệ mới nổi, nhằm tạo lợi thế trên chiến trường trong tương lai đã biến trí tuệ nhân tạo (AI) thành trung tâm của cuộc chơi quyền lực toàn cầu.

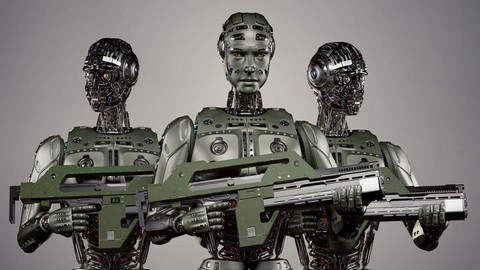

Ở nhiều quốc gia, sự phát triển trong lĩnh vực vũ khí tự động (AWS) đang tiến triển nhanh chóng với sự gia tăng của xu hướng vũ khí hóa AI dường như đã trở thành một sự phát triển gây mất ổn định cao. Nó mang lại những thách thức an ninh phức tạp không chỉ cho những người ra quyết định của mỗi quốc gia mà còn cho tương lai của nhân loại.

Ngày nay, AI đang dẫn chúng ta đến một chiến trường chiến tranh thuật toán mới không có ranh giới hoặc biên giới, có thể có hoặc không có con người tham gia, trong khi AI sẽ không thể hiểu và có thể kiểm soát toàn bộ hệ sinh thái của con người trong không gian mạng, không gian địa lý, và không gian (CGS). Do đó, chính ý tưởng về việc vũ khí hóa AI, nơi một hệ thống vũ khí, một khi đã được kích hoạt trên CGS, có thể chọn và tấn công các mục tiêu là con người và không phải con người mà không cần đến sự can thiệp của người thiết kế hoặc vận hành là con người, đang gây ra nỗi sợ hãi lớn.

Bài viết trên Forbes bình luận: Khi AI, học máy (machine learning) và học sâu (deep learning) phát triển hơn nữa, chuyển từ khái niệm sang thương mại hóa, sự tăng tốc nhanh chóng về sức mạnh tính toán, bộ nhớ, dữ liệu lớn và giao tiếp tốc độ cao không chỉ tạo ra sự đổi mới, đầu tư và ứng dụng điên cuồng mà qua đó còn tăng cường nhiệm vụ cho các con chip AI. Sự phát triển và tiến bộ nhanh chóng và liên tục này cho thấy AI đang trên đường cách mạng hóa chiến tranh và các quốc gia chắc chắn sẽ tiếp tục phát triển hệ thống vũ khí tự động mà AI có thể thực hiện được.

Ngày nay, ứng dụng của AI vào quân sự rất đa dạng: Từ điều hướng và sử dụng các phương tiện hải quân, trên không và thông qua các thiết bị bay không người lái (drone), cho đến việc dùng AI để đưa ra ước tính thiệt hại, triển khai hệ thống tên lửa "bắn và quên" và sử dụng hệ thống tĩnh để tự động hóa mọi thứ từ hệ thống nhân sự và bảo trì thiết bị cho đến việc triển khai drone giám sát, robot và hơn thế nữa.

Nó đưa chúng ta đến một câu hỏi quan trọng: Việc sử dụng AI trong chiến tranh hiện đại nên được cho phép, hạn chế hay cấm hoàn toàn? Không thể phủ nhận: Hệ thống vũ khí tự trị (không cần sự can thiệp của con người) được cho là giúp giảm chi phí vận hành của hệ thống vũ khí, sử dụng nhân lực hiệu quả hơn, tăng tốc độ, độ chính xác, độ bền cao, tầm tiếp cận và khả năng phối hợp trên chiến trường.

Bài toán về quản lý

Tuy nhiên, việc vũ khí hoá AI cũng đặt ra 2 vấn đề lớn: Một là Vai trò của lập trình viên và công nghệ lập trình. Nếu và khi một lập trình viên cố ý hoặc vô tình lập trình vũ khí tự động để hoạt động vi phạm luật nhân đạo quốc tế thì con người khi đó sẽ kiểm soát việc vũ khí hóa AI như thế nào? Hơn nữa, vì hệ thống vũ khí tự trị tập trung vào phần mềm, nên trách nhiệm về lỗi, thao tác thiết kế và sử dụng hệ thống phải nằm ở đâu? Điều đó đưa chúng ta đến trọng tâm của câu hỏi: khi nào và nếu như một hệ thống tự trị giết người, ai sẽ chịu trách nhiệm cho việc giết người này, bất kể là nó có chính đáng hay không?

Hai là Những thách thức về an ninh mạng. Các thuật toán không có khả năng miễn nhiễm với phần mềm độc hại, chúng hoàn toàn có thể bị thiên vị và thao túng. Và vì học máy sử dụng máy móc để đào tạo các máy khác, điều gì sẽ xảy ra nếu có phần mềm độc hại hoặc thao tác cố tình xâm nhập dữ liệu đào tạo? Trong khi các nguy cơ bảo mật ở khắp mọi nơi, các thiết bị được kết nối làm tăng khả năng vi phạm an ninh mạng ở các vị trí từ xa.

Hồi tháng 1-2017, CNN đưa tin Nghị viện Châu Âu đã soạn thảo đề án hợp pháp hóa việc sử dụng robot trong đời sống hằng ngày. Tuy nhiên, cơ quan này nhấn mạnh đề án phải có quy định thiết kế công tắc “tiêu diệt”, phòng khi robot mất kiểm soát, khống chế lại loài người.

Nghị viện kêu gọi các robot khi thiết kế phải tuân thủ luật robot, trong đó quy định các nhà sản xuất phải chế tạo ra những robot “nhân đạo”, không phục vụ cho mục đích hủy diệt, giết người, và trên mỗi robot phải công tắc khẩn để "giết" robot (khiến nó dừng hoạt động) trong trường hợp cần thiết.

Đề án cũng quy định những nhà sản xuất robot cần phải mua bảo hiểm như kiểu bảo hiểm ô tô để đề phòng những thiệt hại do robot gây ra. Quyết định này không phải là “lo xa” mà dựa vào tình hình thực tế khi nhiều nhà khoa học cũng đã lên tiếng cảnh báo về nguy cơ AI lấn át con người.

Đứng đầu những người phản đối ứng dụng rộng rãi AI trong cuộc sống là nhà vật lý lý thuyết lỗi lạc Stephen Hawking. Hồi tháng 10-2016, phát biểu từ Cambridge (Anh), Hawking nhấn mạnh trí tuệ nhân tạo (AI) có thể trở thành thảm họa lớn nhất trong lịch sử nhân loại nếu những cỗ máy biết "tư duy" này vượt khỏi tầm kiểm soát.

Hawking cảnh báo: “Sự trỗi dậy của các hệ thống AI có thể là điều tuyệt vời nhất nhưng cũng có thể là thứ tồi tệ nhất xảy ra với con người. Chúng ta không biết mọi chuyện sẽ đi theo hướng nào".

Cuộc đua cải tiến vũ khí trên toàn cầu như vậy đã đi đến đỉnh điểm là ứng dụng hệ thống vũ khí tự trị vào tác chiến, đặt ra nhiều thách thức cho công cuộc quản lý để ngăn chặn những mối nguy tiềm ẩn.

Xem thêm: lmth.72499_aoh-ihk-uv-ib-oat-nahn-eut-irt-oc-yugn-iouc-yk/ehgn-gnoc/nv.moc.nagnoc